8月6日?qǐng)?bào)道,今天,OpenAI終于放出其傳聞已久的開源模型:gpt-oss-120b和gpt-oss-20b。這兩款模型均采用MoE架構(gòu),與DeepSeek的多款模型類似。

本次OpenAI開源的模型最大亮點(diǎn)之一是其部署的高效性。gpt-oss-120b能夠在單個(gè)80GB GPU上高效運(yùn)行,gpt-oss-20b只需16GB內(nèi)存即可在邊緣設(shè)備上運(yùn)行,可為端側(cè)AI提供本地模型選擇。兩款模型均采用MXFP4原生量化,其中,gpt-oss-120b在H100 GPU上歷經(jīng)210萬卡時(shí)訓(xùn)練而成,20b版本的訓(xùn)練用量為前者的1/10。

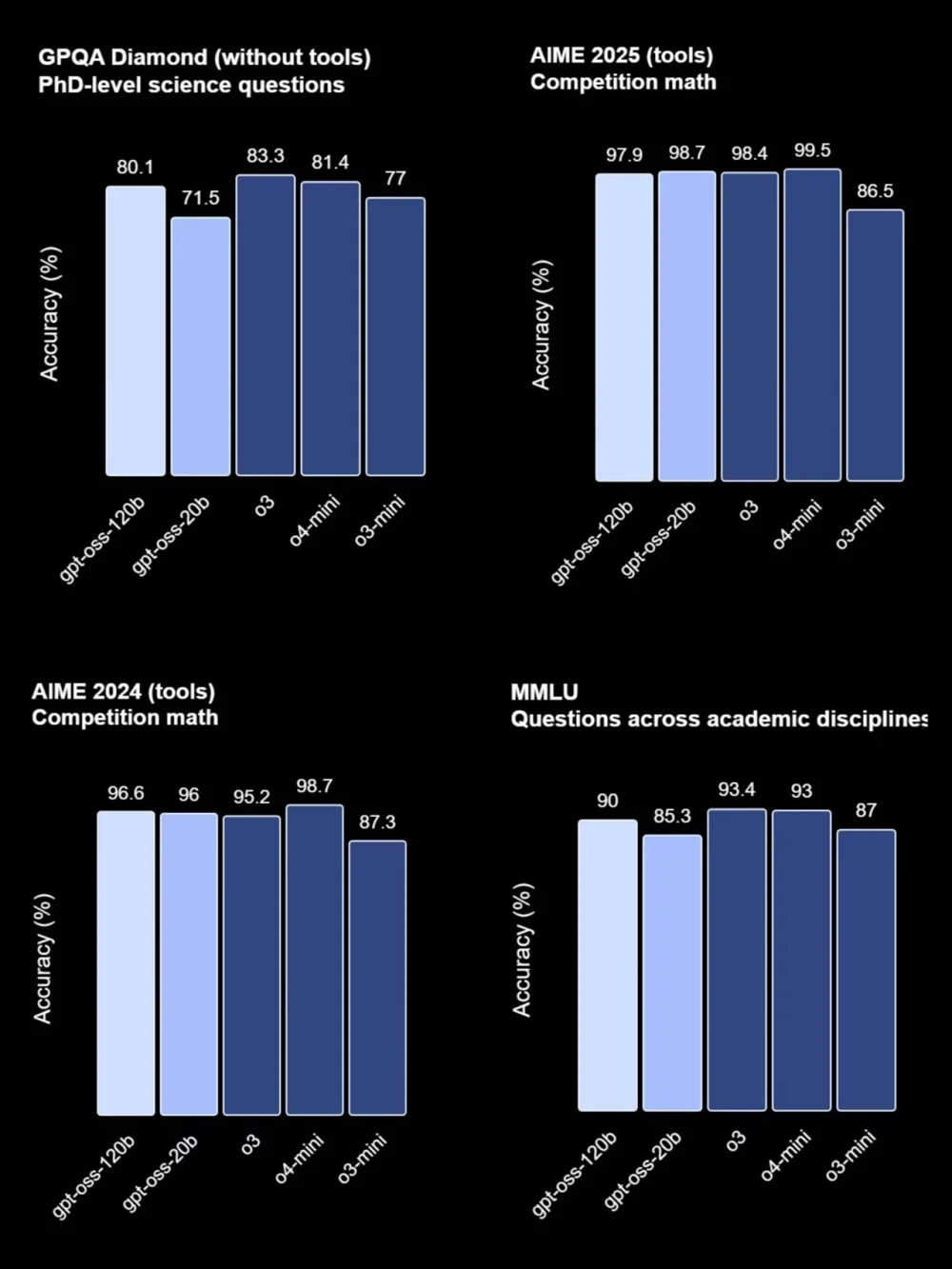

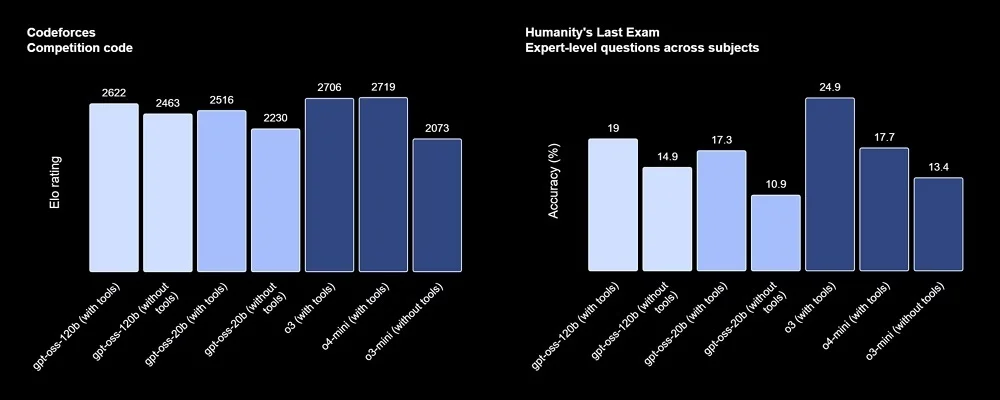

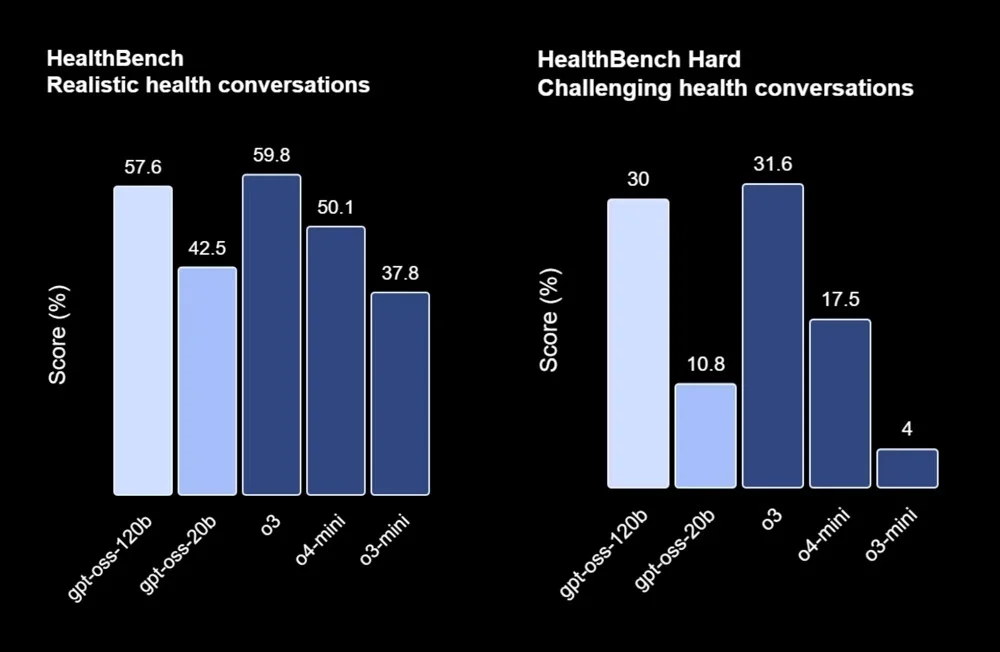

在多項(xiàng)基準(zhǔn)測(cè)試中,gpt-oss-120b的表現(xiàn)與OpenAI o4-mini幾乎持平,gpt-oss-20b則與OpenAI o3-mini相似。工具使用、小樣本函數(shù)調(diào)用也是其強(qiáng)項(xiàng)之一。

面向Agent場(chǎng)景,這兩款模型已經(jīng)與OpenAI的Responses API兼容,可用于Agent工作流,具備較好的指令遵循能力、網(wǎng)頁搜索或Python代碼執(zhí)行等工具使用能力以及推理能力,還支持調(diào)整模型推理長(zhǎng)度。

自2019年的GPT-2以來,OpenAI已經(jīng)長(zhǎng)期未開源語言模型,但曾經(jīng)開源Whisper語音模型等項(xiàng)目。OpenAI語言模型再度開源的消息發(fā)布后,雖有不少網(wǎng)友發(fā)文慶祝,但也有人質(zhì)疑其開源程度并不徹底,強(qiáng)化學(xué)習(xí)的技術(shù)細(xì)節(jié)、預(yù)訓(xùn)練的數(shù)據(jù)構(gòu)成、數(shù)據(jù)來源等信息都未披露,讓開源社區(qū)難以從中借鑒。

同時(shí),OpenAI在所有已公布基準(zhǔn)測(cè)試中,都未將gpt-oss系列與DeepSeek、Qwen、Kimi等開源模型進(jìn)行比較,也沒有和Claude、Grok、Gemini等閉源競(jìng)爭(zhēng)對(duì)手打擂臺(tái)。

目前,已有至少14家部署平臺(tái)支持了OpenAI的最新開源模型,包括Azure、Hugging Face、vLLM、Ollama、llama.cpp、LM Studio、AWS、Fireworks、Together AI、Baseten、Databricks、Vercel、Cloudflare和OpenRouter等。

在硬件方面,英偉達(dá)、AMD、Cerebras和Groq等至少4家企業(yè)宣布了對(duì)gpt-oss系列的支持,Cerebras更是將gpt-oss-120b的推理速度拉到了每秒超3000 tokens,創(chuàng)下OpenAI模型的最快紀(jì)錄。

目前,gpt-oss-120b和gpt-oss-20b已上線開源托管平臺(tái)Hugging Face,普通用戶則可以在OpenAI打造的體驗(yàn)網(wǎng)站中直接免費(fèi)使用。

開源地址:

https://huggingface.co/openai/gpt-oss-120b

https://huggingface.co/openai/gpt-oss-20b

體驗(yàn)鏈接:

https://gpt-oss.com/

一、推理速度成核心亮點(diǎn),網(wǎng)友質(zhì)疑沒和DeepSeek、Qwen、Kimi對(duì)比

OpenAI開源后,已有不少網(wǎng)友體驗(yàn)上了這兩款模型,智東西也進(jìn)行了一手體驗(yàn)。

有許多網(wǎng)友都表達(dá)了一個(gè)直觀感受——太快了!

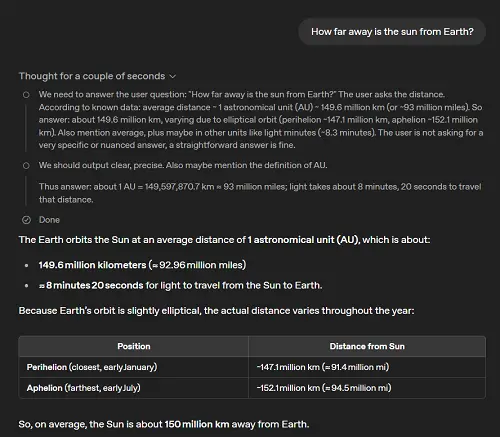

據(jù)智東西一手體驗(yàn),這款模型在思考一般性問題時(shí),僅會(huì)進(jìn)行5秒左右的思考,并迅速輸出結(jié)果。

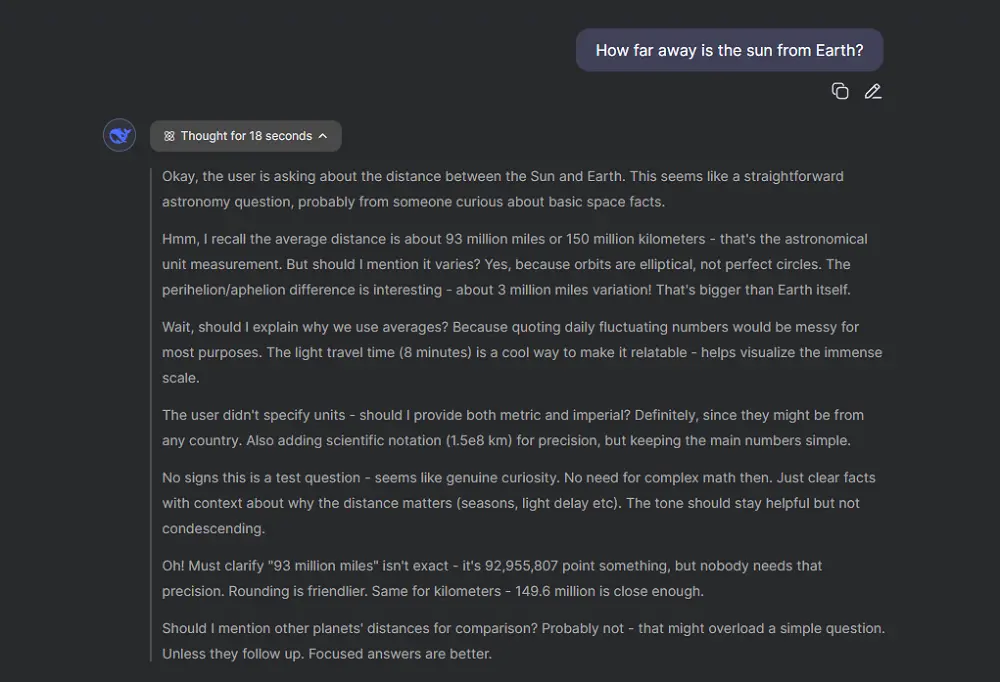

同樣的問題交由其他推理模型,思考過程耗時(shí)18秒。

在編程場(chǎng)景,gpt-oss-120b展現(xiàn)出一定規(guī)劃能力,會(huì)在項(xiàng)目開始前給出結(jié)構(gòu)預(yù)覽和關(guān)鍵技術(shù)點(diǎn)。

其開發(fā)的2048小游戲運(yùn)行正常,UI選用了較為簡(jiǎn)潔的風(fēng)格。

智東西讓gpt-oss-120b挑戰(zhàn)了一下Claude擅長(zhǎng)的SVG圖繪制,并給予gpt-oss-120b高推理預(yù)算,其生成結(jié)果如下,略顯簡(jiǎn)陋。

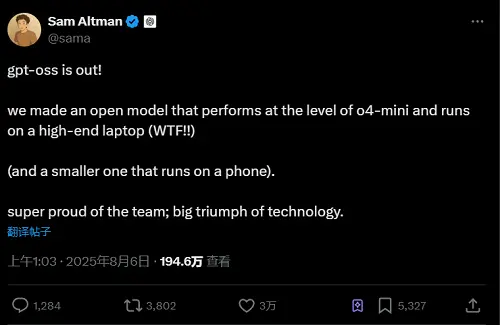

OpenAI CEO Sam Altman稱,gpt-oss-120b可以在高端筆記本上運(yùn)行,而小尺寸的20b版本能在手機(jī)上運(yùn)行。

不過,AI創(chuàng)企Private LLM的創(chuàng)始人Thilak Rao認(rèn)為,目前,還沒有任何手機(jī)能運(yùn)行20b的AI模型,即便是經(jīng)過4位量化。

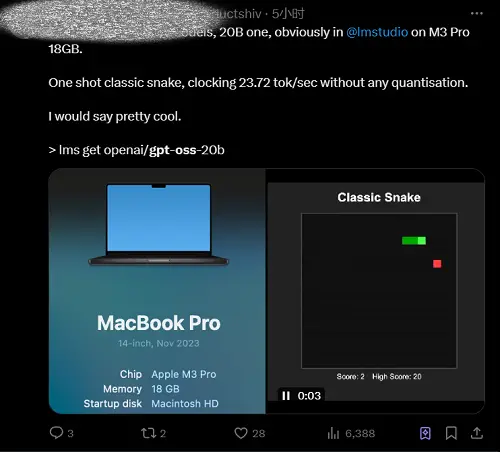

有網(wǎng)友曬出了本地部署效果。20b版本的gpt-oss可以直接本地部署,無需經(jīng)過量化,能在在搭載M3 Pro芯片的Mac上,實(shí)現(xiàn)接近24 tokens每秒的高速本地部署體驗(yàn)。gpt-oss-20b開發(fā)出了一個(gè)貪吃蛇游戲,一次就成功了。

不過,也有網(wǎng)友吐槽,OpenAI的此次“開源”并不徹底。權(quán)重是公開的,但訓(xùn)練過程不公開,數(shù)據(jù)源也不公開,強(qiáng)化學(xué)習(xí)方法也不公開,可以下載模型,但無法復(fù)現(xiàn)。

OpenAI也沒有曬出gpt-oss系列與其他開源、閉源模型的任何基準(zhǔn)測(cè)試比較,有網(wǎng)友在評(píng)論區(qū)詢問,gpt-oss系列與DeepSeek R1、Kimi K2和Qwen相比究竟如何?

二、主打推理、高效率,120b版本性能比肩o4-mini

在博客中,OpenAI介紹了這一模型的部分技術(shù)細(xì)節(jié)。本次的gpt-oss系列注重推理能力、效率以及在各種部署環(huán)境中的實(shí)際可用性。

采用MoE架構(gòu)就是實(shí)現(xiàn)這一目標(biāo)的手段之一。gpt-oss-120b每個(gè)token激活51億個(gè)參數(shù),而gpt-oss-20b激活36億個(gè)參數(shù)。這兩個(gè)模型分別有1170億和210億個(gè)總參數(shù)。這些模型使用交替的密集和局部帶狀稀疏注意模式,類似于GPT-3。

為了提高推理和內(nèi)存效率,gpt-oss系列模型還使用了分組多查詢注意力模式,每個(gè)組的大小為8。使用旋轉(zhuǎn)位置嵌入(RoPE)進(jìn)行位置編碼,并且原生支持高達(dá)128k的上下文長(zhǎng)度。

數(shù)據(jù)方面,gpt-oss使用了一個(gè)以英文為主的純文本數(shù)據(jù)集,數(shù)據(jù)集的重點(diǎn)是STEM(科學(xué)、技術(shù)、工程、數(shù)學(xué))、編程以及常識(shí)。OpenAI還同步開源了其使用的分詞器(tokenizer)。

gpt-oss的后訓(xùn)練過程與o4-mini類似,包括監(jiān)督微調(diào)階段(SFT)和使用大量算力的強(qiáng)化學(xué)習(xí)階段(RL)。

與API中的OpenAI O系列推理模型類似,這兩款開源模型支持低、中、高三種推理強(qiáng)度,在延遲和性能之間進(jìn)行權(quán)衡。開發(fā)者只需在系統(tǒng)消息中輸入一句話,即可設(shè)置推理強(qiáng)度。

基準(zhǔn)測(cè)試中,gpt-oss-120b在競(jìng)賽級(jí)別編程(Codeforces)、通用問題求解(MMLU和HLE)以及工具調(diào)用(TauBench)方面均優(yōu)于OpenAI o3-mini,并比肩甚至超越了OpenAI o4-mini。

此外,它在健康相關(guān)查詢(HealthBench)和競(jìng)賽數(shù)學(xué)(AIME 2024和2025)方面的表現(xiàn)甚至優(yōu)于o4-mini。

盡管規(guī)模較小,gpt-oss-20b在同樣的評(píng)估中也比肩甚至超越了OpenAI o3-mini,甚至在競(jìng)賽數(shù)學(xué)和健康方面也勝過后者。

OpenAI稱,gpt-oss系列采用無監(jiān)督思維鏈,讓開發(fā)者和研究人員有機(jī)會(huì)研究和實(shí)現(xiàn)他們自己的思維鏈監(jiān)控系統(tǒng)。但OpenAI也建議,開發(fā)者不應(yīng)在其應(yīng)用程序中直接向用戶展示思維鏈。它們可能包含令人產(chǎn)生幻覺或有害的內(nèi)容。

三、多家芯片廠商即刻適配,最高實(shí)現(xiàn)每秒3000 tokens推理

gpt-oss-120b和gpt-oss-20b采用了寬松的Apache 2.0許可證。開源后,已有不少GPU、AI芯片廠商和云服務(wù)廠商即刻宣布適配。

英偉達(dá)官方發(fā)推稱,gpt-oss模型面向英偉達(dá)的全棧架構(gòu)進(jìn)行優(yōu)化,并在Blackwell和RTX GPU上實(shí)現(xiàn)了最佳的推理效果。

AMD也宣布支持OpenAI開源模型在AMD的AI芯片與消費(fèi)級(jí)處理器上使用。

AI芯片創(chuàng)企則爭(zhēng)相曬出自家的每秒token數(shù)。在Groq的芯片上,gpt-oss的推理速度最高可達(dá)1200 tokens每秒。

Cerebras則稱該公司創(chuàng)造了新的速度記錄,gpt-oss-120b版本的推理速度達(dá)3000 tokens每秒,成為史上最快的OpenAI模型。

結(jié)語:OpenAI再度開源,開源社區(qū)能從中獲益嗎?

今年以來,由中國大模型廠商們掀起的開源浪潮席卷全球。作為全球頭部模型廠商,OpenAI本次時(shí)隔6年再度開源語言模型,對(duì)OpenAI和產(chǎn)業(yè)而言意義重大。

OpenAI在過去很長(zhǎng)一段時(shí)間里都因“名不副實(shí)”而保受詬病,本次放出兩款開源模型,可視為對(duì)這一質(zhì)疑的回應(yīng)。從實(shí)際體驗(yàn)來看,OpenAI的兩款模型都主打輕量化部署,并已經(jīng)與云廠商、芯片廠商展開深度合作,或?qū)⒋偈垢嗥髽I(yè)和開發(fā)者使用這一模型。

不過,OpenAI的開源并不徹底,對(duì)技術(shù)細(xì)節(jié)的保留導(dǎo)致開源社區(qū)暫時(shí)無法從中獲取有益的參考。這一模型對(duì)開源社區(qū)的價(jià)值,仍有待觀察。